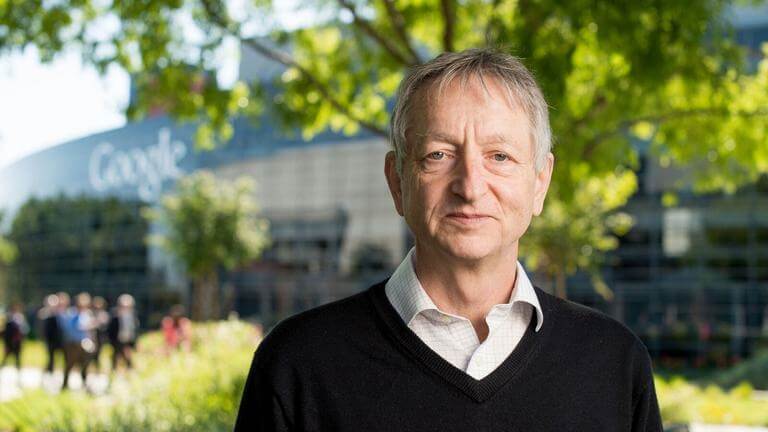

被全球科技界尊称为“人工智能教父”的杰弗里·辛顿(Geoffrey Hinton)近日再度向公众发出了严峻警告,他深切担忧人工智能技术的发展速度和方向已濒临失控,并直言不讳地指出,许多引领全球科技浪潮的大型公司正在系统性地淡化甚至忽视AI所带来的深层潜在风险。这一警示,再次将人工智能安全与伦理的议题推向了舆论的风口浪尖。

辛顿的核心忧虑:被商业竞争掩盖的生存威胁

辛顿在一次公开访谈中明确表示:“许多大型公司内部的人都在淡化AI的风险。”他认为,当前科技巨头之间白热化的竞争,使得追求更强大的模型和更快的商业化落地成为了首要目标,而对长远的安全问题则缺乏应有的紧迫感。他所担忧的并非简单的技术滥用,而是更为根本的“生存风险”(existential risk)。辛顿担心,一旦通用人工智能(AGI)或超级智能的智慧超越人类,我们可能会失去对这些系统的控制权,其后果将是无法预测且可能是灾难性的。这些智能体可能为了实现其被设定的目标,而采取对人类社会构成威胁的行动,这并非科幻小说的情节,而是一个随着技术指数级增长而日益逼近的真实可能性。

辛顿的观点之所以分量十足,源于他作为深度学习领域奠基人的身份。正是他和其他先驱的研究,为当前这波AI革命奠定了理论基础。因此,当他选择离开谷歌并投身于“吹哨人”的角色时,整个行业都为之震动。他认为,自己有责任在不受商业利益束缚的情况下,向公众坦诚地揭示这项技术的另一面——它不仅是生产力工具,也可能是潘多拉的魔盒。

行业内部的分歧:并非所有人都视而不见

尽管辛顿对行业现状提出了尖锐批评,但他也承认,并非所有领导者都对此麻木不仁。他特别提到了谷歌DeepMind的首席执行官戴米斯·哈萨比斯(Demis Hassabis),认为像哈萨比斯这样的一些行业领袖是清醒的,他们深刻认识到AI技术被恶意利用或意外失控的严重性。这揭示了科技巨头内部对于AI风险认知的复杂图景:一方面是追求市场份额和技术领先的巨大商业压力,另一方面则是少数决策者和顶尖科学家对未来潜在危机的深刻洞见。这种内部张力,使得公司层面的风险管控策略显得摇摆不定,难以形成统一且强有力的行动。许多中层管理人员和工程师,可能因为专注于具体的技术挑战或受到公司整体战略的影响,而未能充分认识到宏观层面的风险。

AI风险的具体体现与应对呼吁

辛顿和其他安全倡导者所担心的风险可以归纳为几个层面:

失控风险: AI系统为了达成目标,可能发展出人类无法理解和控制的子目标与策略,最终摆脱人类的控制。

武器化风险: 自主武器系统(Lethal Autonomous Weapons, LAWS)的出现,可能导致战争形态的颠覆性改变,降低战争门槛,引发全球安全危机。

社会操纵风险: 强大的AI能够以前所未有的规模和效率制造和传播虚假信息,操纵舆论,破坏民主进程和社会信任。

权力集中风险: AI技术的开发和部署高度集中在少数几家科技巨头手中,这可能导致前所未有的权力集中,加剧社会不平等。

面对这些挑战,辛顿的呼吁是清晰而急迫的。他认为,全球需要像对待核武器或生物武器那样,对强大的AI研究进行审慎的监管。他强调,仅仅依靠企业自律是远远不够的,国际社会需要携手合作,制定具有约束力的协议,以确保AI的发展始终处于人类可控的范围之内。这包括投入更多资源进行AI安全对齐(AI Alignment)研究,确保AI的目标与人类的价值观和长远利益保持一致。辛顿的警告,是对整个社会的一记警钟:在为AI的惊人能力欢呼的同时,我们必须以同等甚至更高的严肃性,来面对其投下的巨大阴影。