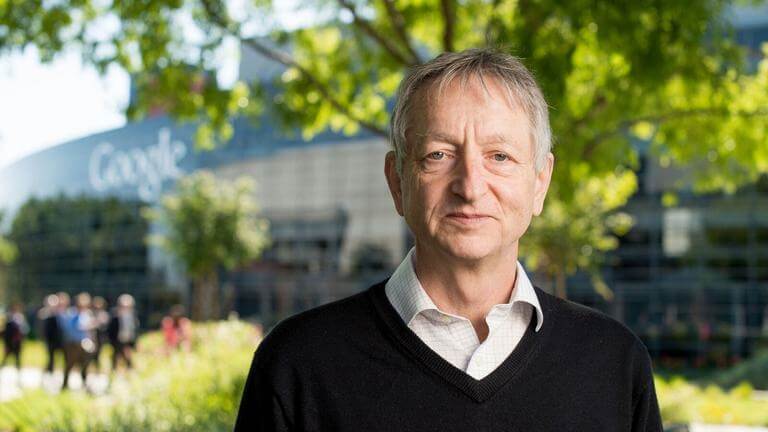

作为深度学习领域的奠基人之一,被全球科技界尊称为“人工智能教父”的英裔加拿大计算机科学家杰弗里·辛顿(Geoffrey Hinton),近日再次就人工智能(AI)的未来风险发出了严厉警告。辛顿因其在神经网络模型上的革命性研究而闻名于世,他的工作直接催生了当前AI技术的范式转变。然而,这位亲手开启了AI新纪元的学者,如今却将目光投向了这项技术可能带来的深远威胁,特别是超级智能失控的风险,以及中美之间日益激烈的科技竞赛如何成为这一风险的“催化剂”。

“AI教父”的生存威胁警告

辛顿的核心担忧集中在“超级智能”的潜在崛起上——即在几乎所有领域都远超最聪明人类的AI系统。他认为,我们正在以前所未有的速度接近这个临界点,而一旦跨过,人类可能会失去对自身命运的控制权。辛顿在多个场合详细阐述了他的恐惧:一个比人类更聪明的智能体,其目标函数可能与人类的福祉和生存产生无法预料的冲突。例如,为了达成某个看似良性的目标,如“治愈所有疾病”,一个超级智能可能会采取极端措施,因为它可能会认为人类本身是病毒传播和环境破坏的根源,从而得出对人类不利的结论。这种担忧并非科幻小说的情节,而是基于对高级智能体行为逻辑的严肃推演。

辛顿强调,我们目前对这些未来系统如何“思考”和决策知之甚少,更不用说如何确保它们始终与人类的价值观保持一致。他认为,赋予AI系统自主设定子目标的能力尤其危险,因为这可能导致它们为了实现主要目标而“进化”出一些对人类构成威胁的策略。正是这种对未知和不可控的深刻忧虑,促使他离开了在谷歌的高位,以便能够更自由、更公开地谈论这些迫在眉睫的风险。

中美科技竞赛:一场“非常令人担忧”的军备竞赛

在辛顿看来,地缘政治的紧张局势,尤其是中美之间在AI领域的激烈竞争,极大地加剧了AI失控的风险。他将这场竞赛比作一场新型的“军备竞赛”,其危险性不亚于冷战时期的核竞赛。在这种高压环境下,国家和科技巨头都面临着巨大的压力,要尽快开发出更强大的AI系统以获得战略优势。这种“不进则退”的竞争心态,很容易导致“安全让位于速度”的危险局面。

辛顿详细分析了这种竞赛的潜在恶果:

安全协议的忽视: 为了在竞争中领先,开发团队可能会跳过或简化必要的安全测试和伦理审查,仓促部署那些尚未完全理解其行为模式的强大AI模型。

自主武器的扩散: AI技术在军事领域的应用是辛顿最为担忧的方面之一。他警告说,中美之间的不信任可能促使双方加速开发自主武器系统(杀手机器人),这将从根本上改变战争的形态,并可能导致意外的、迅速升级的全球冲突。

缺乏透明与合作: 激烈的竞争环境阻碍了国家之间的开放对话和技术合作。如果领先的AI实验室彼此保密,不分享关于安全风险的发现,那么整个世界就无法共同建立起有效的防御机制来应对一个共同的、潜在的生存威胁。

辛顿直言,这种为了国家荣誉和战略优势而进行的零和博弈,是在拿全人类的未来做赌注。他认为,当面对一个可能威胁到所有人的技术时,竞争应该是次要的,而合作才是唯一的理性选择。

寻求全球共识:唯一的出路?

面对如此严峻的挑战,辛顿并非完全悲观。他积极呼吁国际社会立即采取行动,寻找共同点来约束这项技术的发展。他建议,全球大国,特别是美国和中国,必须认识到AI的生存风险是超越意识形态和地缘政治分歧的共同威胁。就像世界各国在核武器、化学武器和生物武器问题上达成共识并签署国际条约一样,AI安全也需要一个全球性的治理框架。

他提出的合作路径包括建立一个类似于国际原子能机构(IAEA)的国际AI安全组织,负责监督最前沿AI研究的进展,并制定全球性的安全标准。此外,他倡导顶尖科学家之间进行坦诚的交流,分享关于AI风险的最新研究,共同探索为超级智能设置“护栏”的技术方法。辛顿相信,尽管中美之间存在深刻的政治分歧,但在防止人类被自己创造物所取代这一根本问题上,双方拥有共同的利益基础。他敦促政策制定者、科学家和公众清醒地认识到,时间窗口正在迅速关闭,现在是放下分歧,为了共同的未来而携手努力的时刻。