随着人工智能(AI)技术,尤其是大型语言模型(LLM)的浪潮席卷各行各业,网络工程师正站在一个技术变革的十字路口。我们不再仅仅是配置路由器和交换机的专家,更需要探索如何将AI融入日常工作流程,以提升效率、自动化复杂任务。在众多AI术语中,有一个看似深奥但至关重要的概念——上下文长度(Context Length)。你可以把它想象成一个“极客旋钮”(Nerd Knob),一个可以精确调节AI性能,使其更好地服务于网络工程特定需求的关键参数。理解并掌握这个旋钮,将是决定我们能否成功驾驭AI浪潮的关键。

什么是上下文长度?一个通俗易懂的解释

让我们抛开复杂的技术定义,用一个简单的比喻来理解。想象一下你正在和一位记忆力超群的朋友交谈。你可以聊上好几个小时,他能清晰地记得你们对话开始时的每一个细节,并将其与当前的话题联系起来,给出非常有深度和相关性的回应。现在,想象和另一位朋友交谈,他的“短期记忆”很差,只能记住你说的最后两三句话。当你提到半小时前的话题时,他会一脸茫然。大型语言模型的“上下文长度”就类似于这位朋友的“记忆力”。它定义了AI在生成回应时能够“记住”并考虑的输入信息的总量。这个总量通常以“令牌”(tokens)为单位来衡量,一个令牌可以是一个单词、一个字符或一个词根。一个拥有更大上下文长度的AI模型,就像那位记忆力超群的朋友,能够处理和关联更多的信息,从而提供更准确、更连贯、更具深度的输出。

为什么上下文长度对网络工程师至关重要?

对于网络工程师来说,我们日常处理的数据量巨大且上下文关联性极强。无论是调试网络故障、分析设备配置,还是编写自动化脚本,上下文都是王道。一个微小的配置错误可能隐藏在数千行代码之中,一个网络性能问题可能需要关联分析数小时的日志文件。这正是上下文长度发挥其魔力的舞台:

处理大型配置文件: 想象一下,你需要AI帮助你审计一个包含数万行命令的防火墙或路由器配置文件,找出其中不合规或存在安全风险的条目。一个上下文长度较小的模型可能会“忘记”文件开头的策略定义,导致分析出现偏差。而拥有巨大上下文窗口(如100万令牌)的模型则可以“通读”整个文件,进行全局性的、高度准确的分析。

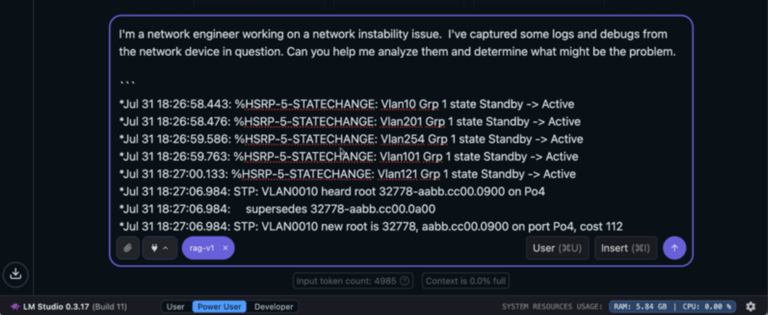

深度日志分析: 当网络出现疑难杂症时,工程师需要查阅来自多个设备的海量日志文件。你可以将这些日志全部输入到一个拥有足够上下文长度的AI模型中,让它帮你关联事件、识别异常模式并定位根本原因。AI的“记忆力”越强,它能发现的潜在关联就越多。

理解复杂的技术文档: 需要快速掌握一个新的网络协议或产品特性?你可以将整篇技术白皮书或RFC文档“喂”给AI,然后就其中的任何细节进行提问。AI能够基于完整的文档内容,为你提供精准的解释和总结,极大地提升了学习效率。

生成精确的自动化脚本: 当你需要编写一个复杂的Ansible Playbook或Python脚本时,你可以提供详尽的需求描述、网络拓扑信息以及现有的配置片段。更长的上下文让AI能够充分理解你的意图和所有约束条件,从而生成更可靠、更贴合实际需求的脚本代码。

权衡与选择:上下文长度不是越大越好

虽然更大的上下文长度带来了显著的优势,但它也并非没有代价。这就像汽车的引擎,马力越大,油耗也越高。同样,处理更长的上下文需要更多的计算资源(GPU内存),并且可能会导致AI响应速度变慢。因此,选择合适的AI模型和上下文长度是一个需要在性能、成本和速度之间进行权衡的过程。对于快速的问答或简单的代码生成,一个较小的上下文窗口可能已经足够,且响应更快。但对于需要深度分析和理解复杂关联的任务,投资于拥有更大上下文长度的模型将带来无与伦比的回报。随着技术的不断进步,AI模型的上下文窗口正在变得越来越大,而成本和速度的瓶颈也在被逐步突破。对于每一位着眼于未来的网络工程师而言,现在正是开始关注并学习如何运用“上下文长度”这个强大旋钮的最佳时机。它不仅是一个技术参数,更是我们解锁网络智能化运维新范式的金钥匙。